Voice Conversion by Cascading Automatic Speech Recognition and Text-to-Speech Synthesis with Prosody

会议:2020 interspeech作者:zhangjingxuan单位:科大讯飞&中科大文章目录abstractintroduction2. background3. proposed method3.1 ASR enabstract使用ASR和TTS级联的方法完成语音转换,ASR用科大讯飞的引擎,TTS用transformer,另外加一个prosody encoder产生韵律标记(建

会议:2020 interspeech

作者:zhangjingxuan

单位:科大讯飞&中科大

文章目录

abstract

使用ASR和TTS级联的方法完成语音转换,ASR用科大讯飞的引擎,TTS用transformer,另外加一个prosody encoder产生韵律标记(建模说话人和文本之外的韵律信息)。在inference过程中,从source speech中提取prosody code加在TTS上,本方法在单语种VCC2020中取得最佳自然度和相似度。

主要创新(1)ASR识别到text量级;(2)引入prosody encoder,使得TTS的输出不是完全偏向target的韵律

introduction

传统ASR-TTS的劣势:(1)源说话人身份特征无法完全从PPGs或者content-related feature中解耦出来;(2)帧级别特征对齐,难以序列建模,限制相似度;

本文主要的网络结构

2. background

transformer-TTS的优点:(1)没有RNN,训练过程高度并行,节省时间;(2)多头attention,可以更好的建模长时依赖。

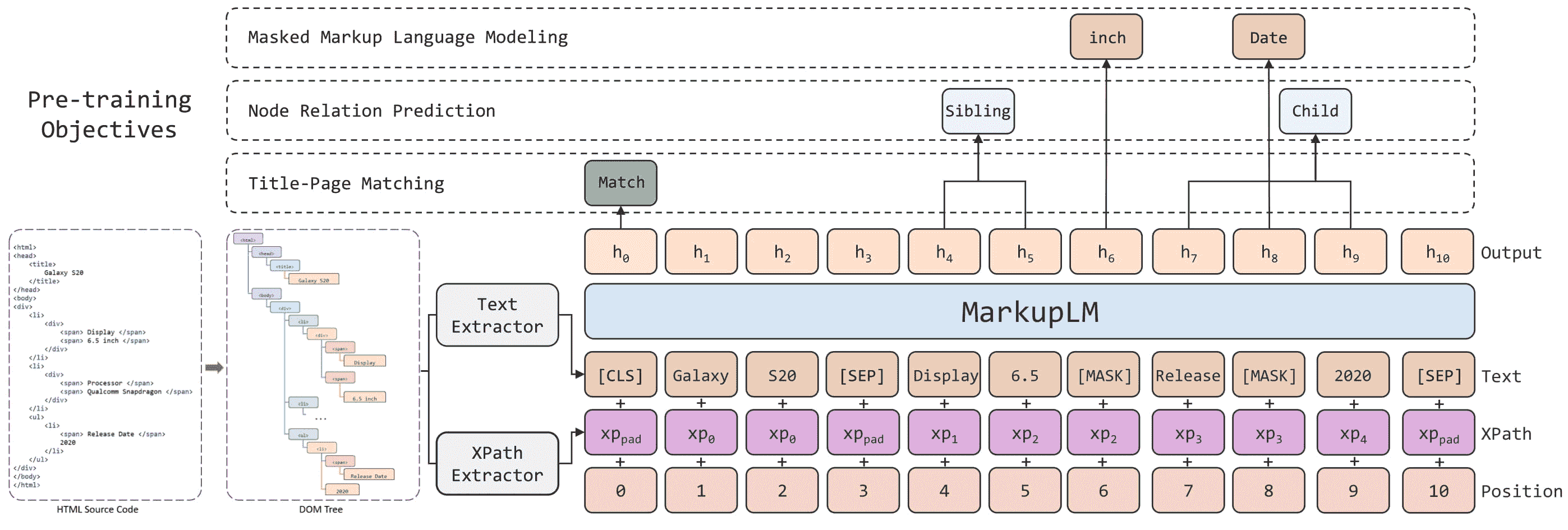

3. proposed method

3.1 ASR engine

ASR引擎将wav识别为text,因此识别精度越高越好,比较了科大的商用引擎和开源的ESPnet的识别精度。

3.2 TTS model

直接用目标说话人的数据训练transformer-TTS容易陷入过拟合,常用做法是用multi-speaker corpus对模型进行预训练,然后用target speaker的数据进行fine-tune。用线性变换之后的x-vector进行说话人身份表示,在decoder中和每一帧进行拼接,

3.3. Prosody transfer

prosody encoder进行全剧信息的韵律编码,是语句中除去说话人身份,文本之外的特征;

训练过程中,想要的韵律信息和说话人信息耦合在一起,引入speaker adversarial loss以固定prosody code是说话人无关的。用一个speaker classifier从prosody code中预测说话人身份,prosody encoder以降低speaker classifier的识别精度为目标进行优化。

prosody encoder的参数只在预训练的时候更新,在finetune的时候固定不变。

4. Experiments

4.1. Experiment conditions

VCC2020的数据集,4个source,4个target,每人70句话

LibriTTS 数据用于预训练,460h,1150个说话人

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)